参考链接

查看python版本

从 NVIDIA 的官网上下载 CUDA 的 pin 文件。这个文件确保 CUDA 仓库的优先级更高,防止与其他仓库发生冲突。

wget https://developer.download.nvidia.com/compute/cuda/repos/wsl-ubuntu/x86_64/cuda-wsl-ubuntu.pin

将下载的 cuda-wsl-ubuntu.pin 文件移动到系统的 /etc/apt/preferences.d/ 目录下,并将其重命名为 cuda-repository-pin-600

sudo mv cuda-wsl-ubuntu.pin /etc/apt/preferences.d/cuda-repository-pin-600

下载cuda11.8的安装包

wget https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda-repo-wsl-ubuntu-11-8-local_11.8.0-1_amd64.deb

将下载的 CUDA 安装包安装到系统中

sudo dpkg -i cuda-repo-wsl-ubuntu-11-8-local_11.8.0-1_amd64.deb

将 CUDA 11.8 的 GPG 密钥复制到系统的密钥环中

sudo cp /var/cuda-repo-wsl-ubuntu-11-8-local/cuda-*-keyring.gpg /usr/share/keyrings/

更新包列表并安装 CUDA 11.8 工具包

sudo apt-get update

sudo apt-get -y install cuda-toolkit-11-8

将 Conda 的路径添加到环境变量中,确保在启动时可以直接使用 conda 命令

export PATH=/home/rachelying/miniconda3/bin:$PATH

保存后输入下面命令重新加载bashrc文件

source ~/.bashrc

打开 ~/.bashrc 文件

nano ~/.bashrc

将 nvcc 编译器和 CUDA 11.8 的相关库路径添加到 PATH 和 LD_LIBRARY_PATH 环境变量中。添加路径的目的是确保在终端中能直接调用 CUDA 的工具和库。

# add nvcc compiler to path for CUDA 11.8

export PATH=$PATH:/usr/local/cuda-11.8/bin

# add cuBLAS, cuSPARSE, cuRAND, cuSOLVER, cuFFT to library path for CUDA 11.8

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-11.8/lib64:/usr/lib/x86_64-linux-gn

使更改立即生效

source ~/.bashrc

验证cuda是否成功安装

nvcc --version

cuda安装成功!!!

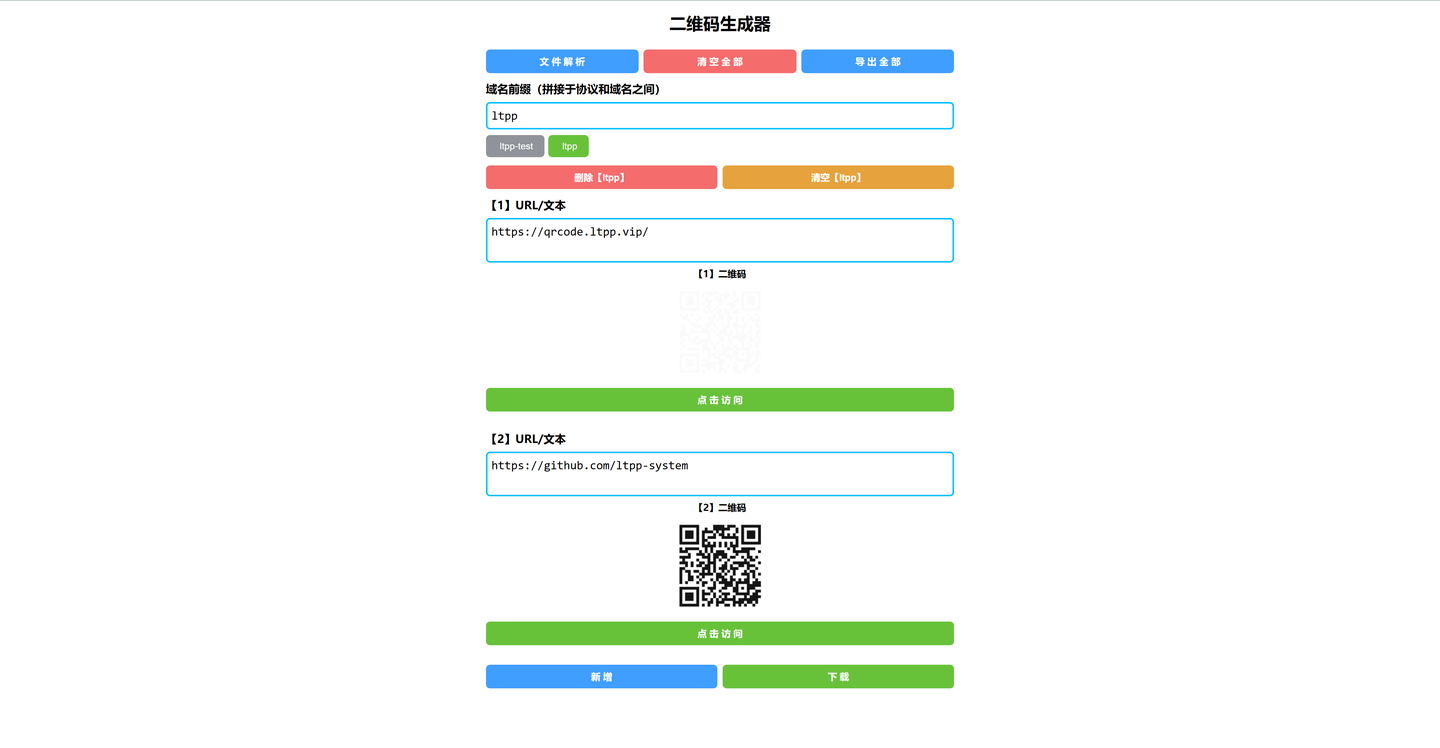

pytorch官网

点击对应选项,下方会生成对应的下载命令语句,将命令语句输入到命令行界面即可。

Compute Platform根据CUDA的安装版本来进行选择,CUDA版本高于11.8选择CUDA 12.1,反之选择CUDA 11.8。

测试torch是否安装成功

成功!!!

cudnn网址

下载cudnn本地安装包

wget https://developer.download.nvidia.com/compute/cudnn/9.5.0/local_installers/cudnn-local-repo-ubuntu2204-9.5.0_1.0-1_amd64.deb

安装下载的安装包

sudo dpkg -i cudnn-local-repo-ubuntu2204-9.5.0_1.0-1_amd64.deb

将 cuDNN 的 GPG 密钥添加到系统

sudo cp /var/cudnn-local-repo-ubuntu2204-9.5.0/cudnn-*-keyring.gpg /usr/share/keyrings/

更新包列表

sudo apt-get update

为 CUDA 11 安装 cuDNN

sudo apt-get -y install cudnn-cuda-11

下载样例文件

sudo apt-get -y install libcudnn9-samples

转到该目录下

cd usr/src/cudnn_samples_v9/mnistCUDNN

没找到,所以找一下该文件放在哪个路径下

sudo find / -name "cudnn_samples_v9" 2>/dev/null

切到该目录下

cd /usr/src/cudnn_samples_v9/mnistCUDNN

编译样例程序

sudo make clean && sudo make

运行样例程序

./mnistCUDNN

cudnn安装成功!!!

返回主目录

cd ~

安装VScode

由于之前用的就是vscode,所以此处略去安装vscode的教程

在WSL命令行中输入

code .